Leo en la prensa española que un padre de familia belga en la treintena, científico y profesional de éxito en la sanidad pública de su país, se quita la vida tras mantener durante seis meses un «diálogo» con Eliza. Eliza es un programa desarrollado en los años sesenta del pasado siglo por Joseph Weizembaum, informático de origen alemán que por aquel entonces trabajaba en el Instituto Tecnológico de Massachussets (MIT); Eliza era capaz de simular una conversación como si estuviese en una sesión de psicoanálisis. Posteriormente se desarrollaron más programas de simulación de conversación, siendo el más famoso y conocido hoy en día el Dr. Abuse, de fácil acceso por Internet.

Sigo leyendo que el suicida estaba obsesionado por el cambio climático y las pocas acciones eficaces que se hacen para paliarlo. Lo sorprendente es que fuese a buscar ayuda en un programa de ordenador y no en organizaciones no gubernamentales de etiqueta verde y ecológica que pudieran canalizar sus inquietudes. Lo único que «pudo» realizar el programa informático es hacer de espejo de las propias opiniones del que lo interrogaba, potenciando sus obsesiones hasta que decidió suicidarse, pues no se «soportaba» más a sí mismo.

Lamentablemente, en nuestros tiempos, el individuo vive en grandes urbes de cientos de miles o millones de personas, pero se siente solo, sin verdadero contacto humano, y busca paliativos en sucedáneos como las redes sociales o el chateo con una máquina que parece humana en sus respuestas pero no lo es, lo que acaba reforzando su alienación y poco a poco lo despoja de los verdaderos sentimientos humanos, robotizándose poco a poco.

En las siguientes líneas trataré de hacer un análisis de lo que se suele llamar, con más presunción que realidad, inteligencia artificial y las implicaciones a las que nos puede conducir su mal uso, tal como está revelando la reciente aplicación ChatGPT o la robotización de los trabajos todavía realizados por seres humanos.

¿Qué es inteligencia artificial?

Una breve búsqueda de la etimología de inteligencia en Internet me dice que el término inteligencia proviene del latín intelligentia, que a su vez deriva de inteligere, que significa optar, escoger; con lo cual el origen etimológico del concepto de inteligencia hace referencia a quien sabe escoger: la inteligencia permite seleccionar las mejores opciones para solucionar una cuestión.

Se utiliza la palabra programa para describir el conjunto de instrucciones que debe ejecutar un ordenador a partir de unos datos para obtener un resultado. La palabra se usó por primera vez para el primer ordenador de carácter general, que fue el ENIAC, cuyo proyecto comenzó a desarrollarse en la Universidad de Pennsylvania en el año 1943, aunque finalmente no se pudo presentar hasta comienzos de 1946.

El primero que acuñó el término inteligencia artificial para el mundo de la computación fue el informático del MIT John McCarthy en 1956, que utilizó el término en una conferencia en Darmouth College sobre la simulación del comportamiento humano mediante ordenadores. También desarrolló la primera versión de un lenguaje de programación de diferenciación simbólica conocido como LISP (List Processing), que fue el primero de los lenguajes que seguían el paradigma funcional.

Estos lenguajes se utilizaron para procesos recursivos, que además admitían funciones recursivas como argumento de los mismos. Posteriormente, a estos lenguajes de paradigma funcional les seguirían los que utilizarían la lógica filosófica desarrollada por Aristóteles y Kant, creando el paradigma lógico para los lenguajes de programación informática. Finalmente, la programación orientada a objetos es la que permite separar los diferentes elementos de un programa y la que más se acerca a cómo expresaríamos las cosas en la vida real.

Debe señalarse que dichos paradigmas de lenguajes informáticos estaban basados, si no copiados literalmente, en procesos de lenguaje y de pensamiento humano. Se estaban implementando en los incipientes ordenadores maneras y modos de trabajar que remedaran lo que llamamos pensar, ese especial proceso de la mente humana con el que intentamos conocer el mundo que nos rodea.

Pero esto último merece un punto aparte. De momento nos debe bastar con que se comenzó a utilizar un nombre incorrecto como inteligencia artificial para un software y un hardware informático que todavía estaba en pañales y que ni remotamente tenía las capacidades de un sencillo PC como el que estoy usando ahora para redactar estas breves notas.

¿Qué es pensar? La lógica matemática y sus paradojas

Una sencilla consulta al diccionario de la RAE me dice que pensar es, en su primera acepción, formar o combinar juicios o ideas en la mente. También es examinar mentalmente algo con atención para formar un juicio. Ambas definiciones llevan implícito que pensar es algo que no depende de las impresiones de nuestros sentidos, que son la forma por la que captamos el mundo a nuestro alrededor y nos relacionamos con él.

Para poder pensar hay primero que razonar, aunque ambos procesos van unidos, y se debe a Aristóteles la primera investigación básica sobre los procesos de razonamiento y sus principios básicos que llamamos lógica, considerándose a Aristóteles como el primero que sistematizó sus procedimientos, siendo, por tanto, el fundador de la misma.

Posteriormente, más de dos mil años después de Aristóteles, el filósofo alemán Inmanuel Kant introdujo la lógica trascendental en su Crítica de la razón pura, donde establece que para poder pensar necesitamos impresiones de nuestros sentidos. El entendimiento por sí solo no puede intuir nada, y los sentidos por sí solos no pueden pensar nada; es necesaria su unión para producir el conocimiento. Como consecuencia, no se aprende filosofía, sino a filosofar.

Aproximadamente un siglo después de Kant se intentó fundamentar la matemática mediante un sistema de axiomas mediante los cuales se podrían deducir todos los teoremas matemáticos aplicando las reglas de la lógica de manera automática. Eso era algo que ya se conocía desde tiempos del matemático y geómetra griego Euclides, que con sus cinco axiomas y las citadas reglas, pudo deducir todos los teoremas geométricos de su tiempo, dando nacimiento a lo que hoy se conoce como geometría euclidiana.

Ese fue uno de los retos que planteó el matemático David Hilbert: dar fundamentos lógicos a las matemáticas de la misma forma que Euclides lo había conseguido con la geometría. Parte del mismo ya se había logrado, pues los principios de la aritmética que incluían los números naturales y las cuatro operaciones básicas ya habían sido establecidos y sistematizados con los axiomas para los números naturales del matemático italiano Giuseppe Peano.

Sin embargo, el matemático austriaco Kurt Gödel demostró, con sus teoremas de incompletitud, que en el caso de la aritmética existían algunas propiedades verdaderas de los números naturales que no son demostrables a partir de los axiomas de Peano. Es lo que se conoce como primer teorema de incompletitud. Extendiendo el caso a cualquier sistema axiomático, el segundo teorema de incompletitud nos dice que existirán, en cualquier sistema que siga las reglas de la lógica formal, axiomas o verdades que no son demostrables, ni tampoco es demostrable su falsedad. Es lo que se conoce como proposiciones indecidibles. Esto trae de inmediato como consecuencia que conceptos como el de verdad se consideren que ya no pertenecen al lenguaje, sino al metalenguaje.

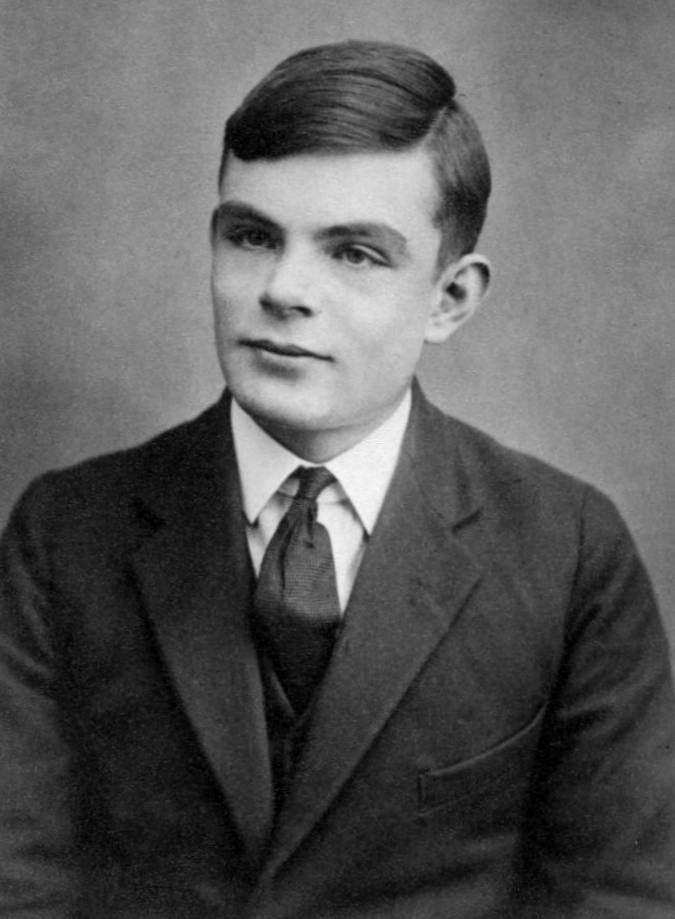

Alan Turing, matemático británico considerado el padre de la computación digital, en su artículo «Systems of logic based on ordinals», escribió que «el razonamiento matemático puede considerarse más bien esquemáticamente como el ejercicio de una combinación de dos instalaciones, que podemos llamar la intuición y el ingenio».

¿Qué es un ordenador? Máquinas de Turing

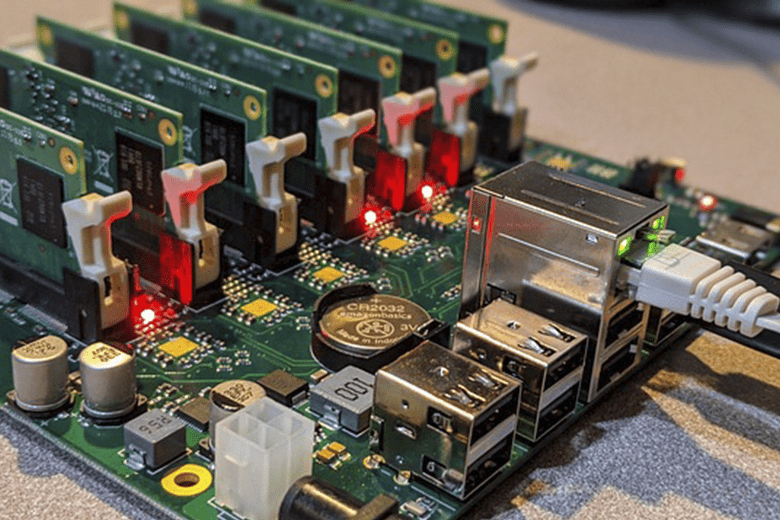

Todo lo anterior es necesario para saber que un ordenador —cuya arquitectura funciona con puertas y operadores lógicos binarios del tipo SI/NO, escritos en código máquina por un programador— solo puede resolver problemas computables, es decir, que puedan ser formulados por un algoritmo, según la conocida tesis de Church-Turing, ambos figuras insignes en el campo de la lógica y la informática.

Hasta ahora hemos estado hablando de los ordenadores y de sus capacidades de cálculo y de posible pensamiento. Pero debemos preguntarnos: ¿qué es un ordenador? Tal como se entiende actualmente es una máquina de Turing de propósito general o máquina-u. Esta máquina de Turing debe decidir de forma automática, es decir, siguiendo un algoritmo, qué funciones matemáticas pueden ser calculadas y cuáles no. Si una función puede ser calculada, la máquina de Turing, tras un tiempo determinado que debe tener fin, nos proporcionará un resultado. Si, por el contrario, la función no puede ser calculada porque no es computable, la máquina continuará con sus cálculos una y otra vez, sin detenerse jamás. Esto es lo que se conoce como el problema de la parada. Es por este problema por el que, a veces, se quedan «colgados» los ordenadores. Se topan en su conjunto de instrucciones con un bucle «sin fin», no computable, que les hace repetir los mismos pasos una y otra vez.

Turing, originalmente, concibió su primera máquina, a la que llamó máquina-a como respuesta al reto de Hilbert que vimos anteriormente, la búsqueda de un procedimiento estrictamente lógico, o en lenguaje actual, un procedimiento de computación, que decidiese la veracidad o no de una proposición matemática. Debe señalarse que la máquina de Turing es virtual, sin existencia real alguna. Sin embargo, se la considera la primera propuesta teórica de lo que podría ser un ordenador. Uno de los problemas de la máquina-a es que tiene siempre un mismo programa y, por tanto, solo realiza una sola tarea. Para superarla, concibió una nueva máquina, la máquina-u (por universal), que sería capaz de tener varias máquinas-a de Turing en su interior. Un ordenador es un ejemplo de máquina-u, pues puede procesar distintos programas. Esto fue un paso decisivo en la historia de los ordenadores, pues ya no se tenía que construir uno específico para cada tarea.

Se deduce de todo esto que un ordenador solo podrá resolver problemas que sean computables, es decir, que estén sistematizados en un algoritmo. Esto último es un conjunto de instrucciones y pasos «mecánicos» sistematizados según reglas lógicas que, según los teoremas de Gödel, contendrán verdades indecidibles no deducibles por algoritmos. Se llega a la natural conclusión de que un ordenador no podrá deducir teoremas que no estén ya predeterminados en su conjunto de instrucciones, que han sido programadas por humanos. Por lo tanto, no podrá «salirse» fuera del algoritmo o de los algoritmos previamente programados en él. La intuición, tal como la entendemos los humanos, como captación directa de una verdad, queda fuera de sus capacidades.

Máquinas frente a personas

«La idea detrás de los computadores digitales puede explicarse diciendo que estas máquinas están destinadas a llevar a cabo cualquier operación que pueda ser realizada por un equipo humano» (Alan Turing, Maquinaria de computación e inteligencia).

En el artículo cuya cita encabeza este punto, Alan Turing se pregunta cómo podemos averiguar si un ordenador se comporta de manera inteligente aunque no lo sea. Para ello desarrolló una prueba, conocida como test de Turing, creando lo que hoy se conoce como enfoque conductista de la IA y evitando dar una definición de lo que es la inteligencia. Tampoco contesta a la cuestión de si las máquinas pueden pensar.

El test de Turing consiste en lo siguiente. Supongamos que una persona puede comunicarse mediante un monitor y un teclado con un ordenador que se encuentra situado fuera del alcance de sus sentidos, por ejemplo, en otra habitación insonorizada. La citada persona realiza una serie de preguntas a través del teclado y obtiene la respuesta a las mismas en el monitor después de un breve tiempo. Si la persona no puede distinguir, a partir de las respuestas obtenidas, si han sido elaboradas por un ordenador o por un ser humano, la máquina en cuestión ha pasado el test de Turing.

Debe señalarse que si la máquina supera el test de Turing ello no significa que tenga consciencia o intencionalidad propia. Como hemos visto, un ordenador o máquina de Turing solo puede resolver procesos computables, pero siempre habrá procedimientos no computables o verdades indecidibles que un ordenador, por definición, no podrá resolver. De momento, la consciencia y la intención son cualidades específicamente humanas.

Turing también fue precursor del otro enfoque de la IA, el llamado enfoque simbólico. Bajo este punto de vista se estudian los sistemas que procesan cadenas de símbolos, tales como las palabras, que son otras de las manifestaciones de la inteligencia humana. Bajo este enfoque se puede simular el comportamiento de un experto. En resumen, se reduce el significado de las palabras y los sistemas que las contienen, tales como las oraciones, a respuestas del tipo SI/NO, para posteriormente trabajar con ellas en sistemas de dígitos binarios; aunque esto último ha generado un intenso debate entre los partidarios de la IA fuerte, que creen que los ordenadores podrán «pensar» algún día tal como lo hacen los seres humanos, y los partidarios de la IA débil, que predican que cualquier manifestación de la inteligencia solo podrá ser simulada por un ordenador.

Desde luego, para el joven profesional belga que se quitó la vida tras chatear con Eliza, este último software hubiera superado el test de Turing, lo que nos abre otra cuestión, y es que si las máquinas son programadas por personas mediante computación informática, estos procedimientos, enfoques de la IA y los programas informáticos que se escriben para ellas también influirán sobre la manera de pensar y sentir el mundo en las personas que las utilicen, tal como pasó en el caso que antes hemos citado.

Retroalimentación de las máquinas

Una reciente noticia aparecida en la prensa española me informa de que las aspiradoras automáticas de una marca que no citaré son entrenadas en el reconocimiento de patrones por los llamados «trabajadores fantasma» de la IA. Todo esto se sabía desde hacía tiempo, que los supuestos robots que nos ayudan en nuestras tareas cotidianas son retroalimentados con reconocimiento de imágenes realizados por humanos.

De manera que, ya que las máquinas por sí mismas no podían reconocer los patrones de los diversos muebles y objetos que se encuentran en una casa, eran estos trabajadores fantasmas quienes, por unos pocos céntimos y en tiempo real, realizaban la categorización y etiquetado de los mismos, de manera que el software implementado en la maquinaria doméstica pudiese realizar su tarea de la forma más eficiente posible.

Lo que hizo saltar la alarma fue que algunas de las imágenes tomadas por las cámaras incorporadas en las aspiradoras se filtraron a las redes sociales. Algunas de estas imágenes colgadas eran una mujer sentada en la taza de un váter, un niño mirando a la cámara de la aspiradora o una familia al completo sentada en la mesa, junto con otras más íntimas.

Inmediatamente surgieron los típicos problemas del tratamiento de datos al recopilar esas imágenes, sin que el usuario tenga una conciencia real del uso que se hace, pues se suele dar el consentimiento para su uso sin saber lo que lleva implícito, tal como estamos viendo en este caso concreto.

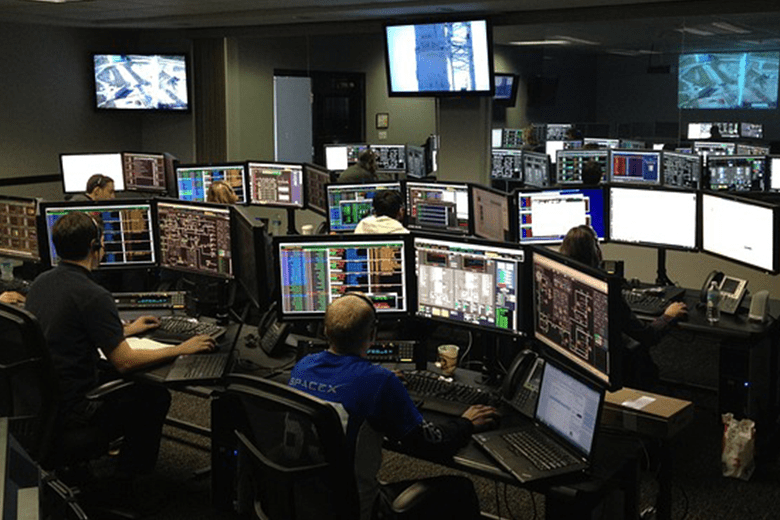

Otra de las herramientas que también utiliza trabajos realizados previamente por seres humanos es la aplicación ChatGPT, desarrollada por la empresa OpenAI. Basta con darle un tema a desarrollar y unas palabras claves y nos realiza un trabajo académico sobre las citadas palabras que, en muchos casos, sobre todos los académicos, es indistinguible del que haría un humano que investigase sobre el citado tema. La citada aplicación realiza una búsqueda en millones de bases de datos desperdigadas por Internet y los combina para crear el escrito que queramos. Se describe a sí misma como «un modelo de lenguaje».

Esto está creando problemas con la autoría de los trabajos, además de la posible violación de los derechos de autor que haría la citada app. Además, en caso de que se la hallase culpable de plagio, ¿a quién habría que culpar? ¿A la empresa desarrolladora, al solicitante, a la misma app? Todo esto genera un debate ético y moral para el cual, obviamente, no estamos preparados. En esta misma línea, la aplicación ChatGPT ha sido vetada en Italia hasta que se conozca el impacto real en la sociedad. Algunas voces autorizadas están pidiendo que se declare una moratoria de seis meses para poder estudiar todas las posibilidades que provocaría el uso generalizado de ChatGPT.

Además hay otro factor a tener en cuenta. Estamos usando el término inteligencia artificial, y ya vimos en los puntos anteriores que la palabra inteligencia no era la adecuada para describir el proceso que realizan los ordenadores. Si encima trabajan con datos previamente creados por humanos, tampoco se puede decir que su trabajo merezca ser llamado artificial, pues lo único que hacen las aplicaciones es reelaborar los datos y trabajos que ya habían realizado las personas.

Repercusión en el pensamiento y la creatividad humana

Esta irrupción tan acelerada de las tecnologías asociadas a la IA traerá consigo una modificación en los criterios artísticos, científicos y filosóficos. De la misma forma que los trabajos manuales provocan cambios en el cuerpo del obrero que los realiza y los métodos burocráticos cambian la manera de pensar y de trabajar de los oficinistas, incluso generando enfermedades propias de cada labor, así las herramientas de la IA ya están provocando cambios acelerados en la sociedad humana. Posiblemente el auge de las enfermedades mentales en nuestra sociedad del siglo XXI esté debido a la interacción continua con máquinas que trabajan con algoritmos, y que nos conducen a pensar también de manera algorítmica casi sin que nos demos cuenta.

Imaginemos que reemplazan a los seres humanos por su mayor eficiencia en muchas de las tareas repetitivas que realizamos habitualmente; esto traerá consigo un gran impacto a la hora de decir lo que somos, pues tradicionalmente el trabajo es lo que nos ha definido ante los demás. Nadie se presenta como una persona soñadora, un aficionado al ajedrez o un filósofo de vocación. Lo normal es que nos presentemos como electricista, periodista, informático o químico.

La repercusión social de un ocio generalizado puede ser inmensa, y esto último en el mejor de los casos, suponiendo que se implementen sistemas de renta básica universal, tal como propone el multimillonario dueño de Tesla y Twitter Elon Musk. La liberación de la maldición bíblica de trabajar lleva implícita la pérdida de lo que nos ha definido socialmente.

Otro factor a tener en cuenta es la merma en las capacidades humanas que trae consigo el uso de estas tecnologías. El uso de la memoria ya ha disminuido, porque un buscador de Internet nos proporciona el dato que queremos a golpe de pulgar en la pantalla del smartphone. La asociación de ideas cada vez es menor porque es más fácil buscar la información en red que deducirla leyendo un texto. El aprendizaje a través de vídeos e imágenes provoca una reducción en el aprendizaje de palabras y por tanto en el pensamiento creativo. Vemos cómo, lentamente, la tecnología nos transforma… y nos debilita.

Problemas sociales, éticos y morales

Recientemente, un químico de la Universidad de Córdoba ha sido suspendido de empleo y sueldo por publicar sus trabajos en otros medios universitarios, teniendo contrato a tiempo completo con dicho centro académico. Este científico está entre los más citados en el mundo universitario, ya que el sistema científico actualmente funciona siguiendo el paradigma «publica o muere».

Nuestro investigador ha publicado más de setecientos artículos en toda su vida profesional; solo en 2023 lleva publicados 58, uno cada día y medio aproximadamente. Es de sobra conocido que no todo lo que se publica en las revistas académicas se puede comprobar experimentalmente por otro equipo de científicos, de manera que esto provoca que aumente la prolijidad en las investigaciones, dado que los resultados no siempre pueden ser testados.

La cuestión es que el científico lleva desde diciembre pasado utilizando la herramienta ChatGPT, según él para pulir sus textos en inglés, pero la duda está presente, ya que es habitual que los científicos compren autorías en otros trabajos para engordar su currículum. Además, la herramienta de IA es especialista en la recopilación de datos e investigaciones para redactarlos como si fuesen creados por una persona.

Pueden surgir otros problemas asociados al uso de tecnologías de IA, como la generación de vídeos de fake news donde a un personaje público se le presenta realizando declaraciones y gestos que jamás hizo, o la reelaboración de noticias por filtros hechos especialmente para los usuarios siguiendo sus perfiles en las redes sociales; esta reelaboración de fake news fue la que hizo que Donald Trump ganara la carrera a la Casa Blanca en las elecciones de 2016.

Conclusión

En este breve trabajo se ha tratado de plantear el problema de la inteligencia artificial desde la raíz, enfocándolo desde el punto de vista filosófico y matemático en primer lugar, para luego trasladarlo al ético y social. Nos guste o no, las herramientas de la IA ya están ahí, y es necesario que aprendamos a manejarlas antes de que ellas tomen el control.

La escritora Irene Vallejo, en su artículo «La revuelta de las cosas», se pregunta sobre la relación que tenemos las personas con los objetos que creamos, haciéndose eco de pinturas de la cultura mochica, en la costa norte de Perú, donde los artistas dibujaron objetos de uso cotidiano con manos y piernas como si hubiesen cobrado vida. En algunas representaciones, dichos objetos están en actitud de servicio hacia las personas, pero en otros dibujos son ellos los que han tomado el control, combatiendo contra seres humanos y esclavizándolos. En palabras de la escritora, «los mochicas anticiparon nuestras inquietudes contemporáneas al plasmar un terror profundamente arraigado ante el poder que adquieren ciertos artefactos al escapar de nuestras manos».

Así pues, la pregunta que encabeza este artículo sigue en pie; inteligencia artificial, ¿aliada o enemiga? Espero que el paciente lector, si ha llegado hasta aquí, pueda encontrar la respuesta en el uso que le demos todos y cada uno de nosotros. Hemos avanzado mucho desde el punto de vista científico y tecnológico, pero este avance no ha sido acompañado en el plano filosófico y moral. Necesitamos una nueva filosofía que nos reconecte con nuestra esencia espiritual, pues somos algo más que un algoritmo. Es con esa esperanza con la que termino estas líneas.

Bibliografía

La computación Turing: pensando en máquinas que piensan. Rafael Lahoz Beltra. Ed. National Geographic.

Del ábaco a la revolución digital; algoritmos y computación. Vicenç Torra. Ed. RBA.

El sueño de la razón; la lógica matemática y sus paradojas. Javier Fresan, Ed. RBA.

Artículos de prensa consultados

«Una medicina no se puede vender sin probar. Con la IA debería pasar lo mismo», por Rodrigo Alonso, ABC, 03-04-2023.

«Bélgica registra un primer caso de suicidio inducido por un chat de inteligencia artificial», por Enrique Serbeto, ABC, 03-04-2023.

«Ni es artificial ni es inteligente», por Eugeny Morozov, El País, 02-04-2023.

«La “ética” artificial es una impostura», por Eric Sadis, El País, 26-02-2023.

«Imaginemos una vida sin trabajar», por Sergio C. Fanjul, El País, 19-02-2023.

«El día que los robots provocaron un cataclismo bursátil», por Agustín Fernández Mallo, El País, 01-02-2023

«Los trabajadores fantasma de la inteligencia artificial», por Manuel G. Pascual, El País, 08-01-2023.

«Noticias del futuro», por Rosa Montero, El País Semanal, 18-02-2023.

«La inteligencia artificial se lanza a reorganizar el mundo», por Andrea Ricci/Kiko Llaneras, El País, 29-01-2023.

«La revuelta de las cosas», por Irene Vallejo, El País Semanal, 09-12-2022.