La inteligencia artificial (IA) está de moda, y plantear hoy día si esta tiene límites parece un postulado propio de un ludita, uno de esos artesanos ingleses que en el siglo XIX protestaron contra las nuevas máquinas que destruían empleo; telares industriales o máquinas de hilar eran las amenazas de una profesión que sentía peligrar sus puestos de trabajo y salarios. La nueva máquina es ChatGPT, una IA que amenaza nuevamente el futuro laboral de los seres humanos.

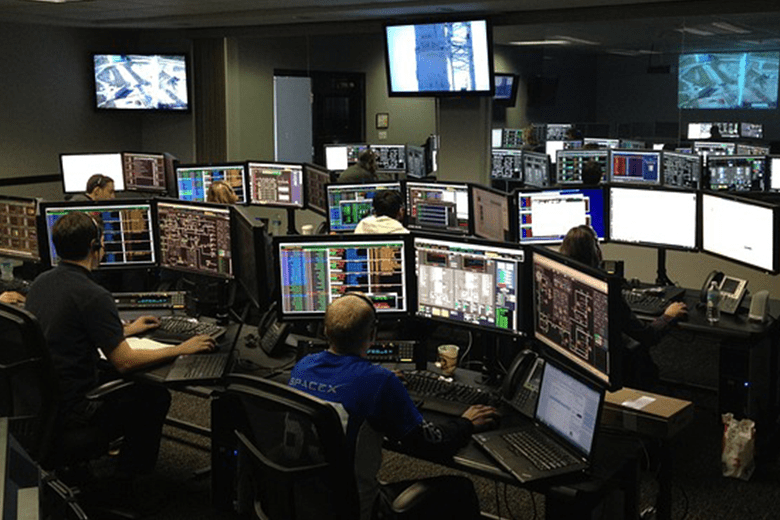

ChatGPT es el chatbot del que todo el mundo habla. Con diez millones de usuarios activos cada día en su primer mes de lanzamiento, por delante de Instagram o TikTok, es una web de uso gratuito a la que se le pueden formular preguntas sobre cualquier cosa, algo así como un oráculo moderno del que esperamos nos depare los mejores augurios.

ChatGPT o Generative Pre-trained Transformer, es un modelo generativo que pretende replicar el lenguaje humano prediciendo la palabra más probable que va a aparecer en un texto. La mejor forma de comprender el alcance de ChatGPT es mantener una conversación con él. Interactuar con ChatGPT genera una experiencia misteriosa, comenzando porque, a medida que conversamos con el sistema, este va a mejorar su entrenamiento, aunque sus creadores advierten al usuario que no comparta información sensible en la conversación con el chatbot.

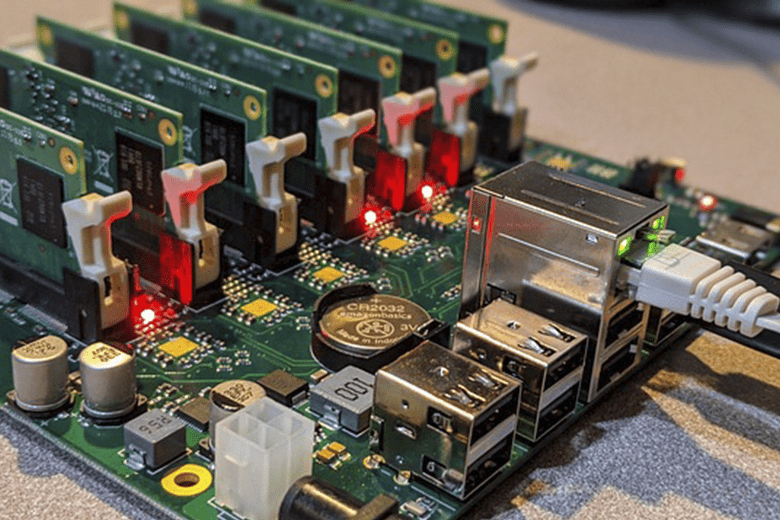

Según sus propias palabras, «ChatGPT funciona utilizando una arquitectura de red neuronal llamada Transformer, que es capaz de aprender patrones en grandes conjuntos de datos de lenguaje natural. En esencia, el modelo se entrena con grandes conjuntos de datos de texto y aprende a predecir la siguiente palabra o conjunto de palabras en una oración, dada una secuencia de palabras previa».

Son muchas las IA que se están investigando, modelos como regresión lineal, regresión logística, análisis discriminante lineal, árboles de decisión, Naive Bayes o redes neuronales profundas, entre otras, que son utilizados para resolver una gran variedad de problemas relacionados con el Machine Learning, siendo unos algoritmos más apropiados que otros para determinadas tareas (3).

Pero no son pocos los especialistas que pretenden situar a la IA en su justo lugar. El término inteligencia artificial fue inventado en 1956 por John McCarthy con el fin de dar nombre al campo de la informática que se dedica al estudio y diseño de máquinas inteligentes. El test que determina si una máquina es capaz de engañar a un ser humano, haciéndose pasar por humana, es el test de Turing, una prueba que hasta ahora no ha sido superada, aunque hay investigadores que afirman lo contrario y ChatGPT podría ser uno de esos ejemplos. Según Erik Larson , el test de Turing resulta complicado en esencia porque la comprensión del lenguaje natural requiere muchas inferencias de sentido común, que ni son ciertas lógicamente ni resultan a menudo demasiado probables.

El filósofo John Searle afirmó en 1980 que las máquinas nunca serían tan inteligentes como el ser humano y para demostrarlo propuso una nueva prueba denominada la habitación china. Planteó una situación en la que una mujer china y un ordenador conversan en lenguaje chino, consiguiendo el ordenador engañar a la mujer, quien piensa que está hablando con un ser humano. Searle propuso sacar el ordenador y colocarse él mismo en su lugar, siendo consciente que no sabía chino, aunque, siguiendo las instrucciones del programa de la máquina, consigue mantener una conversación con la mujer china. Searle no entiende nada porque no conoce el idioma, solo reproduce las instrucciones del programa. La cuestión clave es si el ordenador entiende la conversación que ha mantenido con la mujer y si es consciente de que no la entiende.

Es precisamente en el campo de la conciencia, de la comprensión, donde se encuentra uno de los límites de la IA. El experto en computación Erik Larson ha declarado que los avances actuales de la IA no nos acercan más a tener una inteligencia artificial similar a la humana. Larson, autor de El mito de la inteligencia artificial. Por qué las máquinas no pueden pensar como nosotros lo hacemos (Shackleton books), afirma que existe la convicción de que estamos en una trayectoria inevitable hacia la singularidad tecnológica, la llegada de una inteligencia artificial fuerte similar a la humana. La diferencia fundamental entre la forma de pensar de una persona y el funcionamiento de una máquina está en la inferencia, en el proceso lógico de concluir algo basándose en lo que uno ya sabe y observa. Respecto a ChatGPT, Larson afirma que el chatbot no sabe de qué está hablando: «Si le haces la pregunta correcta, producirá respuestas sin sentido, lo que llamamos alucinaciones de IA».

En la misma línea se ha pronunciado Noam Chomsky, quien, junto a dos expertos en IA, firmó un artículo de opinión en The New York Times calificando a ChatGPT como una falsa promesa. Chomsky afirmó que podrá llegar ese momento largamente profetizado en el que las mentes mecánicas superen a los cerebros humanos, no solo cuantitativamente en términos de velocidad de procesamiento, sino también cualitativamente en términos de perspicacia intelectual y creatividad artística, pero ese logro aún no ha llegado. La mente humana no busca inferir correlaciones brutas entre terabytes de datos, sino crear explicaciones.

A nivel legal, la Unión Europea quiere limitar el alcance de la IA porque considera que hay que garantizar que los europeos puedan confiar en esa tecnología. En la regulación estará prohibido el uso de la IA para explotación de personas vulnerables, identificación biométrica a distancia, sistemas de puntuación social o técnicas subliminales. El Gobierno italiano ha prohibido el uso de ChatGPT en Italia por infringir el GPDP (Garante para la Protección de Datos Personales).